Le HDR est une technologie qui améliore considérablement la qualité de l’image en élargissant la plage dynamique d’un écran - cela signifie des lumières plus lumineuses, des ombres plus sombres et plus de détails dans les deux. Il utilise également une gamme de couleurs plus large qui fait ressortir les couleurs.

De nombreux joueurs n’ont toujours pas eu la chance de découvrir ce qu’est la 4K, mais le monde de la technologie évolue rapidement et selon ses normes, la 4K est déjà une vieille nouvelle.

Le HDR fait fureur maintenant !

Mais alors que 4K est assez simple (en ce sens que tous les écrans 4K comportent le même nombre de pixels), le HDR est beaucoup plus vague et osons dire prédateur dans la façon dont il tient les promesses qu’il fixe. Cela n’aide certainement pas les choses qu’il existe plusieurs normes pour le HDR comme HDR10, HDR10+, DolbyVision, et plus qu’ajouter à la confusion.

Nous sommes donc ici pour dissiper toute la confusion en expliquant d’abord ce qu’est le HDR et comment il est censé fonctionner, puis en analysant les normes d’encodage une par une et en expliquant comment elles fonctionnent réellement.

Qu’est-ce que le HDR ?

Le principe derrière le HDR est simple : améliorer l’expérience visuelle en élargissant la plage dynamique. HDR signifie, après tout, High-Dynamic Range, par opposition à SDR ou Standard-Dynamic Range.

La plage dynamique est la différence entre les parties les plus claires et les plus sombres d’une image. Il y a plus que le contraste, mais vous en comprendrez l’essentiel si vous le comparez au contraste.

L’augmentation de la plage dynamique devrait donner une image avec des ombres plus sombres et des lumières plus lumineuses tout en conservant les détails de ces ombres et lumières.

Nous devons également garder à l’esprit que, pour utiliser le HDR, vous aurez d’abord besoin d’un contenu qui le prend en charge. Cela s’applique principalement aux films, bien que certains jeux vidéo le prennent également en charge, et il y a même une tentative de diffusion HDR, comme vous le verrez bientôt.

Le discours marketing ici est simple : si vous sentez que les films semblent délavés sur votre téléviseur SDR, procurez-vous un téléviseur HDR et vous obtiendrez une véritable expérience cinématographique dans le confort de votre salon.

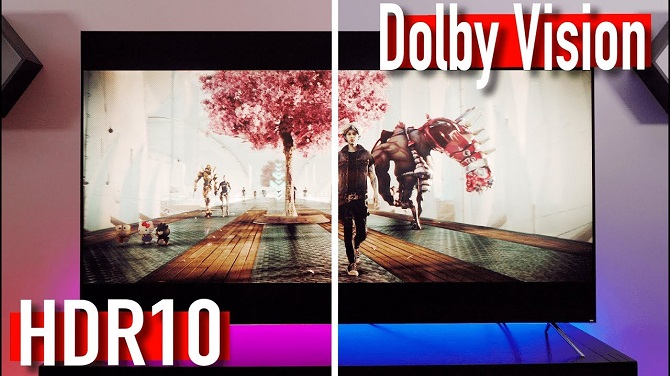

HDR10

Traduire la prémisse en pratique se déroule aussi bien que ce à quoi vous vous attendiez si vous étiez cynique, surtout si vous utilisez HDR10.

Il s’agit de la norme d’encodage la plus répandue pour HDR, en partie parce qu’elle est open source, de sorte que les fabricants n’ont pas à payer de redevances pour l’afficher sur leurs écrans. Il a également l’avantage de prendre en charge le plus de contenu. Mais il a un défaut majeur.

HDR10 s’appuie sur des métadonnées statiques. Cela signifie que votre téléviseur recevra des informations sur les couleurs les plus claires et les plus sombres d’un film. Votre téléviseur ajustera alors sa luminosité pour s’adapter au mieux à ce film.

Il y a deux problèmes majeurs avec cela :

- Votre téléviseur peut ne pas être en mesure de gérer le HDR du tout. La plupart des contenus HDR sont classés avec l’idée que les couleurs les plus brillantes seront affichées à une luminosité de 1000 nits. La plupart des téléviseurs HDR économiques ne prendront en charge qu’une luminosité maximale de 300 nits au mieux. Cela signifie que votre téléviseur attribuera sa propre valeur de luminosité maximale à la couleur la plus brillante du film et essaiera de déterminer les proportions à partir de là. Par conséquent, la plupart des films auront une meilleure apparence en SDR qu’en HDR sur ces téléviseurs.

- Même si votre téléviseur a un bon HDR, le fait que les métadonnées statiques n’utilisent que deux points de référence pour un film entier peut être un gros problème. Disons que vous regardez une horreur qui est globalement faiblement éclairée, mais qu’il y a une scène d’explosion super lumineuse. Eh bien, votre téléviseur peut afficher tout le film plus lumineux qu’il ne devrait l’être en raison de la luminosité de cette explosion.

Dolby Vision

Contrairement à HDR10, qui est une norme d’encodage open source, Dolby Vision appartient à Dolby et il résout en fait les deux problèmes que nous venons de souligner.

Premièrement, HDR10 n’a pas de normes strictes. Il ne contient que des exigences recommandées que les téléviseurs doivent respecter pour afficher correctement le contenu HDR. C’est pourquoi vous pouvez acheter des téléviseurs HDR10 qui rendent le contenu HDR pire que le SDR. Il suffit que le téléviseur puisse recevoir des signaux HDR pour être commercialisé en tant que téléviseur HDR – cela n’a rien à voir avec sa capacité à afficher des images en HDR approprié…

Dolby, en revanche, est plus strict quant aux spécifications que les téléviseurs doivent avoir pour le prendre en charge. Et parce que les fabricants doivent payer des redevances pour mettre en œuvre cette technologie propriétaire, ils sont moins susceptibles de l’installer dans un téléviseur qui n’est pas adapté au HDR. Tout cela pour dire que vous ne trouverez probablement pas un téléviseur Dolby Vision qui craint quand il s’agit d’afficher du contenu HDR.

Ce qui est également formidable, c’est qu’il s’appuie sur des métadonnées dynamiques. Cela signifie que le téléviseur sait à quel point les couleurs les plus claires et les plus sombres sont censées être image par image ou scène par scène, plutôt que de ne recevoir que deux valeurs pour un film entier.

Avec tout cela à l’esprit, il est prudent de dire que Dolby Vision est supérieur au HDR10, à la fois sur papier et dans la pratique. Le seul inconvénient (mis à part le prix) est que moins de contenu est créé pour Dolby Vision que pour HDR10, mais heureusement, les téléviseurs Dolby Vision peuvent toujours afficher le contenu HDR10 en HDR.

HDR10+

Il était évident dès le départ que les Métadonnées Statique utilisées par HDR10 poseraient un problème pour sa longévité. Ainsi, lorsque vous prenez la nature open source de HDR10 et que vous ajoutez des fonctionnalités de métadonnées dynamiques, vous obtenez HDR10+.

Les avantages ici sont évidents – plus de contenu pris en charge et un prix moins cher que Dolby Vision.

Mais cela ne résout que le deuxième problème décrit dans le segment sur HDR10. Le premier est toujours présent – vous pouvez facilement trouver des téléviseurs prenant en charge HDR10 + mais dotés de capacités HDR de niveau poubelle qui ruinent l’expérience de visionnage plutôt que de l’améliorer.

HLG

Enfin, nous voulons mentionner HLG ou Hybrid Log-Gamma.

Le problème avec les autres encodages HDR est qu’ils ne sont pas compatibles avec la diffusion. Pour voir quelque chose en HDR, il faudrait spécifiquement prendre en charge le HDR. Et ici, le contenu du câble ne pouvait tout simplement pas suivre les DVD, les Blu-Ray et les services de streaming.

La BBC et la NHK se sont donc associées pour créer HLG – une forme de HDR qui pourrait être diffusée de telle sorte que les gens avec des téléviseurs HDR puissent voir le contenu en HDR tandis que les gens avec SDR TV pourraient regarder cette même émission en SDR.

HLG n’est peut-être pas aussi beau que tous les autres types de HDR, mais c’est un moyen ingénieux de plaire à la fois au SDR et à la foule HDR.

Moniteurs HDR

Avant de clore les choses, nous souhaitons consacrer une partie de cet article aux moniteurs HDR, car ils suivent des normes complètement différentes de celles des téléviseurs HDR.

C’est vrai! Si vous pensiez que les choses étaient déroutantes jusqu’à présent, attachez votre ceinture !

Les moniteurs de jeu ne sont pas annoncés comme HDR10, HDR10+ ou Dolby Vision. Au lieu de cela, vous trouverez des désignations telles que DisplayHDR400, HDR600, HDR1000, etc.

Ces moniteurs sont certifiés VESA. Et pour la première fois, le nombre qui vient après le HDR n’est pas un non-sens – il vous indique en fait quelle est la luminosité maximale que le moniteur peut atteindre. Vous pouvez trouver le résumé complet des spécifications DisplayHDR ici.

Désormais, tous les moniteurs de jeu HDR ne sont pas certifiés VESA. Vous pouvez toujours en trouver qui comportent le HDR et nous sommes juste censés les croire sur parole. Ne le faites pas. Vous le regretterez si vous le faites. La fonctionnalité est techniquement là, dans la mesure où elle peut être activée et désactivée, mais cela rendra les jeux plus mauvais.

En fait, même DisplayHDR400 peut être insuffisant lorsqu’il s’agit d’offrir une bonne expérience HDR. Nous dirions que DisplayHDR600 est le plus bas que vous devriez atteindre si vous êtes sérieux au sujet des jeux en HDR.

Conclusion

Le passage de SDR à HDR améliore sans doute l’expérience de visionnage plus que le passage de 1080p à 4K.

Mais même si vous pouvez être sûr que chaque moniteur 4K affiche le nombre de pixels annoncé, les moniteurs HDR ne disposent pas toujours d’un bon HDR. Cela est principalement dû au fait qu’il existe de nombreuses normes d’encodage.

Alors passons-les rapidement en revue :

- HDR10 est complètement obsolète de nos jours. Il persiste uniquement à des fins de marketing.

- HDR10+ est capable de grandes choses, mais tous les téléviseurs qui le prennent en charge ne sont pas correctement spécifiés.

- Dolby Vision est sans doute le meilleur standard, mais c’est aussi le plus cher.

- HLG est une tentative d’amener le HDR à la diffusion.

Et enfin, si vous recherchez un moniteur HDR, assurez-vous qu’il est au moins certifié VESA, bien que ceux qui veulent de bonnes capacités HDR devraient prendre au moins DisplayHDR 600.

Ou, si tout cela semble déroutant, vous pouvez toujours consulter ce guide où nous avons compilé les meilleurs moniteurs HDR du marché.

![HDR10 contre HDR10+ contre Dolby Vision [Guide 2024]](/uploads/hdr10-contre-hdr10-contre-dolby-vision.jpg)